데이터센터를 위한 차세대 제온 스케일러블 프로세서 제품군으로 선보일 ‘사파이어 래피즈(Sapphire Rapids)’ 는 인텔의 퍼포먼스 코어와 새로운 가속 엔진을 결합, 더욱 다양하고 복잡한 워크로드를 수행해야 하는 데이터센터 환경에 최적화된 성능을 제공한다. 특히 인텔은 ‘사파이어 래피즈’에서 AI 워크로드 전반에서 상당한 성능 향상을 제공하는 AMX(Advanced Matrix Extensions), 데이터센터 확장에서의 오버헤드로 작용하는 일반적인 데이터 작업 환경을 오프로드하는 데이터 스트리밍 가속기(DSA), 그리고 가속기 및 장치에 대한 효율적인 전송, 동기화 및 신호 전송을 지원하는 액셀러레이터 인터페이싱 아키텍처(AIA) 등을 제공한다. 또한 PCIe 5.0, CSL 1.1, DDR5 및 HBM 기술의 지원과 함께, EMIB 패키징 기술을 활용해 단일 프로세서 인터페이스의 이점을 유지하면서 확장성을 제공하는 타일 방식의 모듈식 SoC 아키텍처를 기반으로 한다.

클라우드 및 통신 서비스 공급자가 프로세서의 오버헤드를 줄이고 성능을 높일 수 있게 하는 프로그래밍 가능한 네트워킹 장치인 ‘인프라 처리 장치(IPU)’ 에서는, FPGA 기반 IPU 레퍼런스 플랫폼인 오크 스프링스 캐년(Oak Springs Canyon)과 전용 ASIC 기반 IPU인 마운트 에반스(Mount Evans)를 공개했다. 인프라 작업을 IPU로 오프로드 할 경우 클라우드 서비스 제공 기업은 서버 CPU의 100%를 고객에 임대할 수 있다. 그리고 AI와 HPC, 고급 분석 워크로드의 가속을 위한 Xe HPC, ‘폰테 베키오(Ponte Vecchio)’는 다양한 공정으로 만들어진 타일을 포베로스, EMIB 패키징으로 조합해 구성되며, A0 실리콘이 이미 45 TFLOPS FP32 이상의 처리량, 초당 5TB 상당의 메모리 패브릭 대역폭 및 초당 2TB 이상의 연결 대역폭을 제공한다고 밝혔다.

|

| ▲ 인텔은 ‘아키텍처 데이’를 통해 차세대 데이터센터를 위한 아키텍처 혁신을 소개했다 (자료제공: Intel) |

|

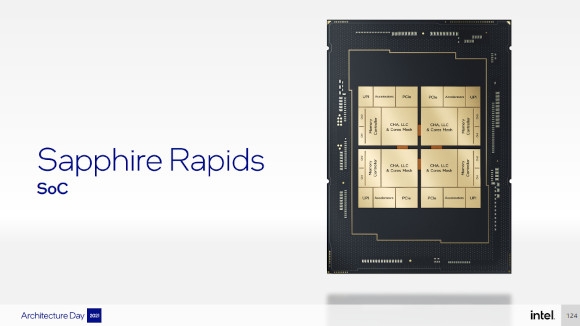

| ▲ ‘사파이어 래피즈’는 멀티 타일 방식의 모듈형 아키텍처를 사용할 것으로 소개되었다 (자료제공: Intel) |

|

| ▲ AMX의 도입은 AI 워크로드 처리 성능을 크게 끌어올릴 것으로 기대된다 (자료제공: Intel) |

인텔의 차세대 제온 스케일러블 프로세서로 선보일 ‘사파이어 래피즈’는 더욱 다양한 유형의 워크로드를 다루어야 하는 복잡하고 까다로운 데이터센터 환경을 위한 워크로드 최적화 환경 구현의 기반이 되며, 특히 클라우드, 마이크로서비스 및 AI와 같은 탄력적인 컴퓨팅 모델에서 높은 성능을 제공할 수 있게 구성되었다. 그리고 인텔은 ‘사파이어 래피즈’ 프로세서와 플랫폼에 있어, 프로세서와 서버 단위의 ‘노드 성능’, 이 노드들이 모이고 연결되어 구성되는 ‘데이터센터 성능’ 모두를 최적화하기 위해, 기존의 단일 다이 구성을 벗어나 ‘멀티 타일’ 방식 모듈형 아키텍처를 사용하며, EMIB 패키징 기술과 고급 메시 아키텍처를 기반으로 단일 프로세서 인터페이스의 이점을 유지하면서 높은 확장성을 제공할 수 있을 것이라고 기대했다. 이 아키텍처에서는 모든 쓰레드가 모든 위치의 타일 리소스에 접근 가능하며, 전체 SoC에서 낮은 지연율과 높은 대역폭을 제공한다.

‘사파이어 래피즈’는 크게 전통적인 코어와 가속기로 조합된 ‘컴퓨트’ IP, PCIe 5.0, CXL 1.1, UPI 2.0 등으로 구성된 ‘I/O’ IP, DDR5, 옵테인, HBM 지원 등을 제공하는 ‘메모리’ IP로 구성된다. 그리고 이러한 구성 요소들이 모여서 만들어진 타일이 크게 네 개까지 하나의 프로세서로 패키징되는 모습이다. 이 중 ‘컴퓨트’ IP는 인텔의 퍼포먼스 코어와 새로운 가속 엔진으로 구성되어 있는데, ‘퍼포먼스 코어’는 기존 대비 IPC 성능 향상과 함께 새로운 명령어 셋, 멀티태넌트 환경에서의 성능 지속성 등이 특징으로 꼽혔다. 특히 AI 연산 성능을 높이는 AMX(Advanced Matrix Extensions)의 지원과 함께, 프로세서 내장 가속기들과의 매끄러운 연결을 위한 AIA(Accelerator Interfacing Architecture), FP16 유형 지원, 새로운 캐시 관리 기술 등이 퍼포먼스 코어에서 중요한 점으로 소개되었다.

특정 유형의 작업에서 프로세서의 부하를 덜고 성능을 높이는 가속 엔진의 경우, 데이터 스트리밍 가속기(DSA)는 데이터 이동 작업의 오프로드를 통해 39% 정도 더 많은 프로세서 시간을 중요한 연산 작업에 활용할 수 있게 하고, QAT(Quick Assist Technology)는 최대 400Gb/s 암호화 성능과 함께 프로세서 부하를 98%까지 줄인다. 그리고 인텔의 AIA는 사용자 영역에서 네이티브 디스페치, 시그널링, 동기화 등을 가능하게 하며, 코어와 가속 엔진 사이의 일관성, 공유 메모리 공간을 제공하는 등, 가속기 및 장치에 대한 효율적인 전송, 동기화 및 신호 전송을 지원한다.

I/O 측면에서는, PCIe 5.0과 CXL 1.1 지원과 함께, 소켓간 연결을 위한 UPI 2.0 지원이 소개되었다. 최대 16GT/s 대역폭의 x24 UPI 링크가 프로세서당 최대 4개까지 제공되며, 이를 통해 이전 대비 8소켓 구성에서 성능 최적화를 기대할 수 있게 되었다. 메모리 지원에서는 타일당 2채널의 메모리 컨트롤러로 총 4개 컨트롤러, 8채널의 DDR5 메모리 구성을 사용하며, 프로세서 내부의 LLC 또한 모든 코어에 걸쳐 최대 100MB 이상의 용량을 활용할 수 있다. 또한 프로세서의 타일에 연결되는 HBM 지원을 통해 더욱 높은 대역폭을 요구하는 애플리케이션에 대응할 수 있으며, HBM은 메모리 혹은 DDR 5 메모리의 캐시 형태로 활용할 수 있다.

한편, 사파이어 래피즈에 도입된 AMX는 텐서 프로세싱에도 매우 빠른 속도를 제공하며, 사이클당 2K INT8 및 1K BFP16 연산을 통해 컴퓨팅 기능을 대폭 향상할 수 있다. 인텔은 AVX-512 VNNI 인스트럭션 대비 새로운 인텔 AMX 명령어세트를 사용하면 7배 더 빠른 성능을 기대할 수 있으며, 학습과 추론용 AI워크로드 전반에서 상당한 성능 개선을 제공한다고 소개했다. 또한 데이터센터의 마이크로서비스 모델 환경에서, 사파이어 래피즈는 QAT나 DSA 등의 가속기, 가속기 연결을 위한 효율적인 아키텍처, 메모리 성능 향상 등을 통해, 기존 2세대 제온 스케일러블 프로세서 대비 69%에 이르는 성능 향상을 제공할 수 있을 것이라 제시했다.

|

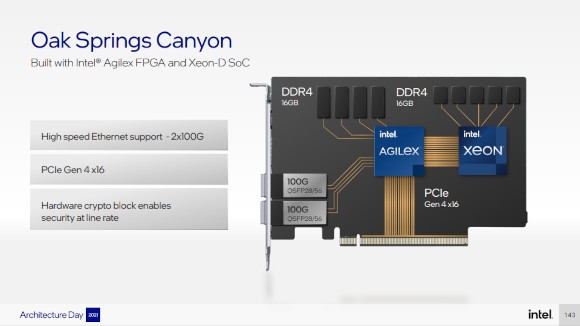

| ▲ ‘오크 스프링스 캐년’은 제온 D 프로세서와 애질렉스 FPGA 조합으로 구성된 IPU 참조 플랫폼이다 (자료제공: Intel) |

|

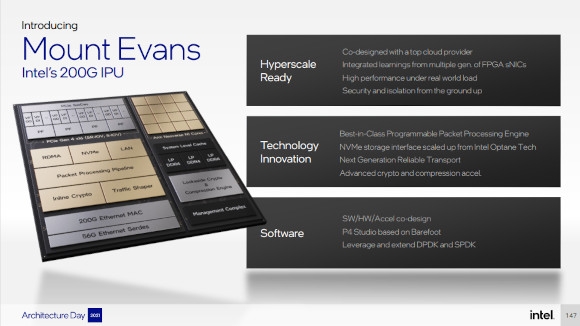

| ▲ 인텔 최초의 ASIC IPU인 마운트 에반스(Mount Evans)에는 Arm 기반 CPU가 탑재된다 (자료제공: Intel) |

인프라 처리 장치(IPU)는 클라우드 및 통신 서비스 공급자가 네트워크와 서비스 관리를 위한 코드를 CPU가 아닌 별도의 프로세서로 실행하도록 해 중앙 처리 장치(CPU)의 오버헤드를 줄이고 성능을 높일 수 있도록 설계된 프로그래밍 가능한 네트워킹 장치다. 인텔은 이 IPU를 활용함으로써 인프라 기능과 테넌트 워크로드를 분리해 테넌트가 CPU를 완전히 제어할 수 있게 하고, 기존에 CPU에서 운영되던 인프라 작업을 IPU로 오프로드하여 CPU 활용률 및 수익 극대화가 가능할 것이라 제시했다. 또한 IPU는 디스크리스 서버 아키텍처를 통해 데이터센터 아키텍처를 간소화하고 스토리지 용량을 효율적으로 사용하면서 성능을 최적화할 수 있는 환경을 구현할 수 있다고 덧붙였다.

인텔의 인프라 가속 포트폴리오는 전용 IPU 기반과 FPGA 기반으로 나뉘며, FPGA 기반에서는 FPGA와 이더넷 인터페이스가 결합된 SmartNIC, 혹은 IPU, FPGA, CPU가 결합된 IPU 플랫폼과 어댑터로 나뉜다. 그리고 이 중 오크 스프링스 캐년(Oak Springs Canyon)은 인텔 제온D 및 애질렉스 FPGA로 구축된 IPU 참조 플랫폼으로, 전력, 효율성 및 성능 면에서 업계 최고 수준의 성능을 보여준다. 오크 스프링스 캐넌은 OVS(Open Virtual Switch)와 같은 네트워크 가상화 기능과 패브릭 및 RoCE v2를 통한 NVMe와 같은 스토리지 기능을 오프로드하고, 강화된 암호화 블록을 제공해 보다 안전한 두 개의 100Gb 이더넷 네트워크 인터페이스를 제공한다. 또한 인텔 오픈 FPGA 스택을 통해 고객에 필요한 최적화된 기능 정의를 지원하며, DPDK, SPDK 등 일반적으로 배포되는 기존 소프트웨어 환경을 사용한 프로그래밍도 가능하다.

코드명 애로우 크릭(Arrow Creek)인 인텔 N6000 액셀러레이션 개발 플랫폼(Intel N6000 Acceleration Development Platform)은 SmartNIC 제품으로 Xeon 기반 서버와 함께 사용하도록 설계되었으며, 통신사업자가 주니퍼 콘트레일(Juniper Contrail), OVS, SRv6와 같은 유연한 가속 워크로드를 제공할 수 있도록 하는 여러 인프라 워크로드를 지원한다. 이 ‘애로우 크릭’은 두 개의 100G 인터페이스를 지원하며, 애질렉스 APGA와 인텔 이더넷 E810 컨트롤러, DDR4 16+1GB 메모리 구성을 갖췄다. 인텔 OFS나 DPDK를 통한 프로그래밍이 가능하며, FPGA나 펌웨어의 PCIe를 통한 보안 원격 업데이트, 보드 상에서의 RoT(Root of Trust) 지원 등이 제공된다.

마운트 에반스(Mount Evans)는 인텔 최초의 ASIC IPU로, 최고의 클라우드 서비스 제공업체와 공동으로 설계 및 개발되었으며, 여러 세대의 FPGA 스마트NIC에서 배운 지식이 적용되었다. 이 IPU는 하이퍼스케일 지원, 고성능 네트워크 및 스토리지 가상화 오프로드를 제공하는 동시에 높은 수준의 제어 기능을 유지하며, 방화벽 및 가상 라우팅과 같은 사용 사례를 지원하는 프로그래밍 기능 패킷 처리 엔진, 인텔 옵테인 기술에서 확장해 NVMe 디바이스를 모방하는 하드웨어 가속 NVMe 스토리지 인터페이스, 퀵어시스트(QuickAssist) 기술을 활용한 고급 암호화 및 압축 가속화 기능 등을 제공한다. 또한 DPDK, SPDK 및 파이프라인을 비롯한 일반적으로 배포되는 기존 소프트웨어 환경을 사용해 인텔의 베어풋 스위치(Barefoot Switch) 사업부가 개척한 P4 프로그래밍 언어를 사용할 수 있다.

이 ‘마운트 에반스’는 최대 4대의 제온 기반 호스트를 200Gb/s 양방향 대역폭으로 지원할 수 있으며, 네트워크 서브시스템에는 ROCE v2 지원 RDMA 블록, 하드웨어 가속 NVMe 오프로드 엔진, QoS와 텔레메트리를 포함한 프로그래머블 패킷 파이프라인, 인라인 암호화 엔진 등을 포함한다. 또한 컴퓨트 컴플렉스의 구성으로는 Arm 네오버스 N1 코어 기반의 16코어 구성과 최대 3채널의 LPDDR4, 암호화와 압축을 위한 엔진, 관리를 위한 별도의 매니지먼트 프로세서를 갖추고 있는 것이 특징이다.

|

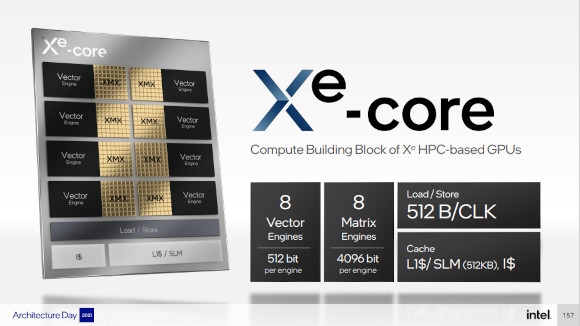

| ▲ ‘Xe 코어’는 8개 벡터 엔진, 8개 매트릭스 엔진을 기본 단위로 한다 (자료제공: Intel) |

|

| ▲ 폰테 베키오 SoC는 5개 공정으로 만들어진 47개 타일의 결합으로 구성된다 (자료제공: Intel) |

|

| ▲ ‘Xe 링크’는 최대 8개 GPU간 직접 연결을 구현, 성능을 확장할 수 있게 한다 (자료제공: Intel) |

폰테 베키오(Ponte Vecchio)는 Xe HPC 마이크로아키텍처를 기반으로 뛰어난 연산 성능과 컴퓨팅 밀도를 제공하여 AI, HPC, 고급 분석 워크로드를 가속화한다. 폰테 베키오는 타일로 표현되는 여러 가지 복잡한 디자인으로 구성되어 있으며, 타일 사이에 저전력, 고속 연결을 가능하게 하는 EMIB 타일을 통해 조립된다. 이들은 포베로스(Foveros) 패키지에 함께 담겨 전력 및 상호 연결 밀도를 위해 활성 실리콘을 3D 적층한다. 고속 MDFI 인터커넥트를 통해 스택을 1개에서 2개로 확장할 수 있다. 한편, 인텔은 폰테 베키오의 A0 실리콘이 45 TFLOPS FP32 처리량 이상, 메모리 패브릭 대역폭 5TBps 이상, 연결 대역폭 2TBps 이상을 제공하고 있다고 덧붙였다.

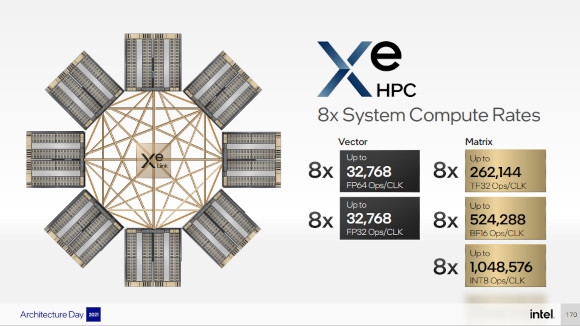

폰테 베키오의 기본 단위는 ‘Xe 코어’로, 이 코어는 8개의 512bit 벡터 엔진, 8개의 4096bit 매트릭스 엔진과 L1 캐시로 구성된다. 이 벡터 엔진은 클록당 256개의 FP32, FP64 연산 혹은 512 FP16 연산을 수행할 수 있고, 매트릭스 엔진은 클록당 2048 TF32, 4096 FP16, BF16, 8192 INT8 연산을 수행할 수 있다. 그리고 ‘슬라이스’ 수준에서는16개의 Xe 코어, 16개의 레이 트레이싱 유닛, 1개의 하드웨어 컨텍스트로 구성되며, ‘스택’ 수준에서는 이 슬라이스가 4개 결합되고, L2 캐시와 4개의 HBM2e 컨트롤러, 한 개의 미디어 엔진, 8개의 ‘Xe 링크’를 갖추고, 최대 2스택 구성으로 8개 슬라이스, 두 개의 미디어 엔진, 8개의 HBM2e 컨트롤러, 16개의 Xe 링크 구성을 제공한다.

한편, 폰테 베키오는 총 5개의 프로세스 노드에 걸쳐 총 47개의 타일이 2D, 3D 패키징을 통해 결합되는 독특한 구조를 가지고 있다. 이 중 8개의 Xe 코어를 포함하는 ‘컴퓨트 타일’은 TSMC의 N5 공정을 사용하며, 포베로스와 함께 3D 스택을 위한 36마이크론 범프 피치를 가지고 있다. 그리고 이 컴퓨트 타일과 결합되는 베이스 타일은 인텔 7공정 기반의 대형 다이로, 복잡한 I/O 및 고대역폭 구성 요소와 PCIe Gen5, HBM2e 메모리, 타일간 연결을 위한 MDFI 링크, EMIB 브릿지 연결 등의 SoC 인프라, 144MB L2 캐시 등을 포함한다. 또한 GPU간 연결을 지원하는 Xe 링크 타일은 타일 당 8개의 Xe 링크와 8포트 임베디드 스위치, 최대 90G SerDes를 갖추고 있으며, TSMC의 N7 공정 기반이다.

‘Xe 링크’는 GPU간 연결을 위한 것으로, 최대 8개 GPU 간 직접 연결을 제공하여, 처리 성능을 최대 8배까지 끌어올릴 수 있게 한다. 그리고 이러한 연결을 기반으로 한 시스템 구성으로는 OAM 폼팩터의 단일 GPU, Xe 링크를 사용해 4개의 폰테 베키오를 연결한 시스템, 그리고 이 4개의 폰테 베키오를 연결한 시스템과 2소켓 사파이어 래피즈 기반 시스템을 결합한 시스템을 제시했다. 또한 전통적인 프로세서와 GPU간 서로 상이한 특성을 효과적으로 활용하기 위한 방법으로는 ‘oneAPI’를 제시했으며, oneAPI 환경을 통해 다양한 성격의 하드웨어로 구성된 이종 환경에서도 특정 프로그래밍 모델에 구애받지 않고 하드웨어의 성능을 최대한 끌어내면서, 생산성을 극대화할 수 있을 것이라 강조했다.

Copyright ⓒ Acrofan All Right Reserved.

마이크로소프트, 이그나이트 2023에서 AI 미래 여는 혁신 ..

마이크로소프트, 이그나이트 2023에서 AI 미래 여는 혁신 .. 네이버 두 번째 IDC '각 세종', "초대규모 AI , 클라우드 등..

네이버 두 번째 IDC '각 세종', "초대규모 AI , 클라우드 등..

오토모빌리 람보르기니 최초의 플러그인 하이..

오토모빌리 람보르기니 최초의 플러그인 하이.. 로터스의 하이퍼 SUV 엘레트라, 국내 판매 가..

로터스의 하이퍼 SUV 엘레트라, 국내 판매 가..